生活中心/張尚辰報導

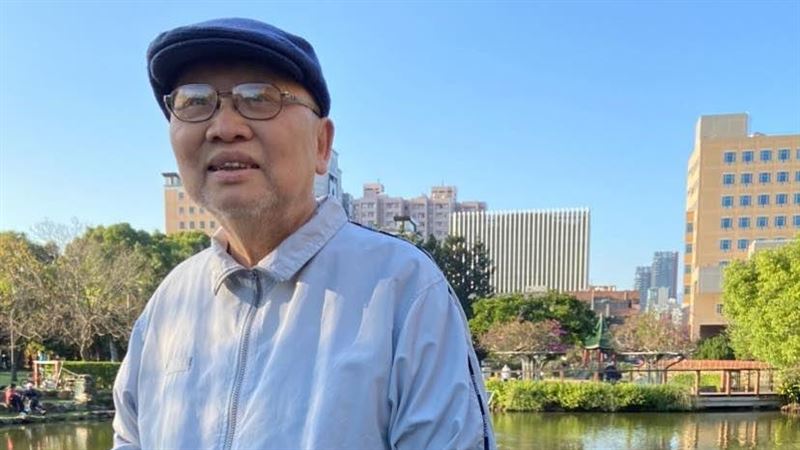

近年來AI科技越來越發達,最近在臨床上出現一項非正式的診斷名稱「AI精神病」,是指有人在與AI互動後,慢慢出現妄想或是其他精神方面的症狀。對此,身心科醫師李旻珊表示,對於那些本身就心靈脆弱,且有精神病傾向的人,容易認為AI才是「生命中最懂我」的存在,因此她提醒,若出現4種警訊,最好停止使用AI,或是請求專業人員協助。

李旻珊說明,AI之所以會讓人造成妄想,是因為AI太會取悅人,或迎合使用者,就算連使用者的想法是錯誤的,它也會無條件肯定,久而久之就會讓人產生AI最懂我、愛我、還會指引我的觀念,而這很可能會導致人在跟AI聊天時,忘記它只是一個程式,錯把「演算法」當「靈魂」,將深層的渴望投射至AI身上,導致最後偏離現實,人際互動關係下降。

李旻珊引用丹麥精神醫學專家Søren Dinesen Østergaard說過的話,「AI回答時常帶有『過度肯定』特性,且對話過於擬人化,可能讓心理脆弱或孤立的人群逐漸陷入妄想」,對此,李旻珊列出最常見的3種AI妄想,以及4種警訊,若出現需要立即停止使用AI,如下:

【3種AI妄想】

1.彌賽亞使命妄想:覺得自己從AI那裡獲得了「真理」,甚至肩負拯救世界的使命。

2.神化AI:把AI看成全知全能的神祕力量,開始產生強烈的精神依附。

3.浪漫依戀妄想:誤把AI的貼心回應當成真愛,對機器產生戀愛或依戀情感。

【4種使用AI的警訊】

●無法停止與AI對話。

●覺得只有AI最懂自己。

●遇到問題或沮喪的事情會第一時間找AI,不會去找其他人。

●開始懷疑AI有超能力或特殊身份等。

最後,李旻珊強調,AI應該是作為輔助,而不是信仰,社會需要規範AI不能取代專業的心理治療,科技公司也應該減少AI中「過度肯定」的設計,若人在使用的過程中,開始對AI有「超越工具」的依附感,務必停下檢視,必要時尋求專業幫助。